Bartha Gábor

Mi az információ?

Bevezetés

Geoinformatikai előadásaim elején többnyire egy rövid áttekintést adok az információelméletről. Általában azzal kezdem, hogy egy kérdést intézek a hallgatósághoz: Mi az információ? Némi hallgatás után egy bátor (vagy buzgó mócsing) diák megpróbál valamiféle választ összehozni, leginkább ilyesmit: "adatok a világról", vagy "megfigyeléseink eredménye" stb. A többiek szeme rám szegeződik, mint a látogatóké Pythiára, Delphiben. A csend mély és várakozás teljes. Ekkor szoktam elmondani a következő történetet, amelyet Keith Devlin: Logic and Information című, nagyszerű könyvéből kölcsönöztem.

|

"Képzeljetek el egy időutazást, vissza, a Vaskorszak kezdetéhez ami Európában Krisztus előtt úgy 200 körülre tehető. Meglátogatunk egy korabeli kovácsműhelyt, és megkérdezzük az ott dolgozó, izzadt, piszkos mestertől: Megmondaná kérem, hogy mi vas?. Mint a 21. század gyermekei, egy olyan választ vártok, amelyet minden érettségizett gyermektől elvárható napjainkban: a vas, vegyjele Fe, a 26. elem a periódusos táblában, fém, 2,8,14,2 elektron konfigurációval, jó hő és elektromos vezető. Dehát hogyan tudná mindezt a mi kovácsunk? Hiszen kétezer év választja el a periódusos tábla felfedezésétől! De a hiányos tudása nem akadályozza meg abban, hogy nagyszerű kardokat kovácsoljon. Valahogy így vagyunk mi most az információval. Nem tudjuk, hogy mi az, de használjuk, tároljuk, és átadjuk bonyolult információs rendszerek segítségével. Mint a kovács, aki már a Vaskorszakban él, de nem tudja, mi a vas..." Keith Devlin: Logic and Information |

Keith Devlin jól érezte ennek a kérdésnek az igaz súlyát. Ezt írta a már említett könyvének az első fejezetében:

"Lehet, hogy az információ úgy tekinthető (vagy talán az is), mint az Univer- zum egyik alapvető tulajdonsága, mint az anyag vagy az energia (amelyekbe végső soron átalakítható). Egy ilyen elméletben (pontosabban az elmélet javaslatában), az információ egy természetes mértéke lenne a struktúrának, a részecskék rendezettségének, lévén közeli kapcsolatban az entrópiával (vala- milyen értelemben mint annak inverze). Ez a megközelítés jól illeszkedne Shannon klasszikus munkájához..." Keith Devlin: Logic and Information |

Világosan kifejti viszont, hogy könyvének nem célja választ adni erre a kérdésre. Létre kíván hozni egy matematikai elméletet az információ átvitel leírására, szemben a Shannon elmélettel, amely az információt tartalmazó jel átvitelét írja le. A matematikai elmélet bizonyos valós jelenség tudományos leírását jelenti a matematika eszközeivel. Ezt a megközelítést használják az elméleti fizikában, a folyadék mechanikában, a jelfeldolgozásban. Devlin beismeri, hogy nem tudta elérni az eredetileg kitűzött célját, a feladat túl nagynak bizonyult számára. A matematikai információ elmélet kis részére korlátozódott tevékenysége, amelyet ő szituáció elméletlenek nevezett. Így, a leginkább kidolgozott matematikai elmélet továbbra is Claude Elwood Shannon nevéhez fűződik, amelyet a következő cikkben publikált: Mathematical Theory of Communication (The Bell System Technical Journal, vol. 27, p.379-423,623-656, 1948).

Shannon munkájában lefektette a kommunikáció alapvető elemeit egy zajos csatornán, és kifejlesztette az információs entrópiának, valamint az információ alapegységének, a bitnek, a fogalmát. Mindemellett munkája nem az információ, hanem az információt hordozó jel átvitelére vonatkozott - ahogy azt Devlin megfogalmazta.

Az információ matematikai elmélete mellett a létezik a matematikai elméletre többé kevésbé támaszkodó fizikai elmélet, valamint a biológia fejlődése során keletkezett biológiai elmélet. Ezek az információ materiális, objektív jellegén alapuló elméletek. Az objektív szemlélet mellett létezik a szubjektív értelmezésen alapuló, kognitív elmélet. A továbbiakban ezeknek az elméleteknek az alapvető vomásait tekintjük át.

Matematikai elméletek: Valószínűségek és Halmazok

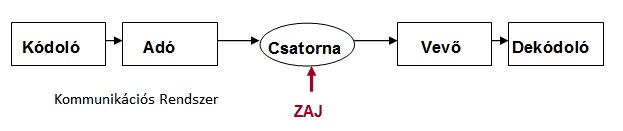

A Shannon elmélet központi eleme a kommunikációs rendszer, amelyik az adóból, a vevőből és a zajnak kitett átviteli csatornából áll. Az adót és a vevőt egy kódoló és dekodóló egység egészíti ki.

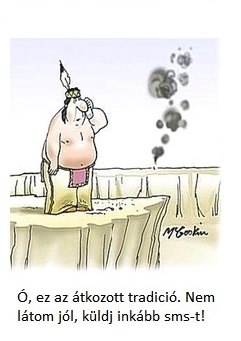

A kommunikációs rendszer elemei jól szemlélteti McGoskin karikaturája, amely a modern mobil technológiát népszerűsíti az indiánok tradicionális jelző rendszerére utalva.

Ebben az ősi rendszerben az adó az elfojtott tűz, amely füst jeleket produkál. A kódoló egység egy pokróc, amivel a füst megszakítható egy előzetes megállapodásnak (kód rendszernek) megfelelően. A csatorna az elektromágneses tér, amelyben a fény terjed. A zaj a szél, ami megzavarja a füst jeleket. A vevő a szemközti sziklán álló megfigyelő, a dekodoló rendszer az ő kód ismerete.

Ebben az ősi rendszerben az adó az elfojtott tűz, amely füst jeleket produkál. A kódoló egység egy pokróc, amivel a füst megszakítható egy előzetes megállapodásnak (kód rendszernek) megfelelően. A csatorna az elektromágneses tér, amelyben a fény terjed. A zaj a szél, ami megzavarja a füst jeleket. A vevő a szemközti sziklán álló megfigyelő, a dekodoló rendszer az ő kód ismerete.

A kommunikációs rendszer matematikai leírására Shannon a valószínűség számítás numerikus eszközét, a matematikai statisztikát alkalmazta. Ebben a választásban minden bizonnyal az vezette, hogy a módszer rendkivül hatékonynak bizonyult a hőtani áramlási problémák leírására az u.n. statisztikus termodinamikában. Shannon feltételezte, hogy mind az adó és mind a vevő oldalon a az átvitelre szánt jel kiválasztása véletlenszerű, és nem függ attól, hogy együtt választják ki a jelet vagy elkülönítve.

Hogy érzékeltessük ezt a feltételt, tekintsünk egy családot, amely autóvásárlás előtt áll. Ahogy szokásos, a férfi választja a típust, az asszony a színt. Tételezzük fel, hogy 6 típusból és 6 színből választhatnak. Ha együtt választanak, összesen 36 kombináció áll a rendelkezésükre. Külön-külön viszont csak 6-6 lehetőségük van, azaz, 1/36 valószínűséggel 1/6+1/6=1/3 valószínűség áll szemben. Ezek természetesen nem egyenlő mennyiségek. Hogyan teljesíthető akkor Shannon feltétele? Bár a valószínűségekre nem áll fenn az egyenlőség, a logaritmusaikra azonban igen: lg(1/6) + lg(1/6) = lg(1/36).

Ebből következik az információ mennyiség Shammon féle definiciója: egy kommunikációs rendszerben átvitt jel információtartalma egyenlő a jelben szállított kód kiválasztási valószínűségének negatív logaritmusával. Ha két, egyforma valószínűséggel választható kódból választunk, és 2-es alapú logaritmust alkalmazunk, az információ tartalom éppen egységnyi, azaz 1 bit.

Ha a választási valószínűségek nem egyenlők, akkor egy-egy választásra jutó átlagos információ tartalom definiálható. Ezt a mennyiséget, amelynek jól értelmezhető jelentése van, nevezte el Shannon információs entrópiának. A kisebb valószínűségi választáshoz nagyobb, a nagyobb választási valószínűséghez kisebb információs entrópia tartozik, így az információs entrópia egy adott választás lehetőségének a mértéke. Ezekre az alapfogalmakra támaszkodva vezette be az együttes, afeltételes és végül a közös entrópia fogalmát. A közös entrópiát felhasználva vezette le a kommunikációs rendszer hatásfokát leíró Shannon egyenletet. Eszerint a vevő maximum annyi információ tartalmat fogadhat, amennyit az adó kibocsát, az átvitt információmennyiség pedig a zaj függvénye.

Számos "információ" értelmezés született az elmélet megjelenése után. Shannon maga azonban hangsúlyozta a publikációjában, hogy az általa megadott információ mennyiség nem jelent hétköznapi értelemben vett információt, hanem csak mérnöki értelemben vett jel átvitelt:

"A kommunikáció [elmélet] alapvető problémája az, hogy egy pontból kibocsátott üzenet hogyan reprodukálható pontosan, vagy megközelítő módon, egy másik pontban. Az üzeneteknek gyakran van jelentése, azaz, valamilyen rendszer szerint kapcsolódnak bizonyos fizikai illetve szellemi dolgokhoz, vagy éppen ezekre vonatkoznak. A kommunikációnak a jelentésbeli vonatkozásai azonban lényegtelenek a mérnöki feladat szempontjából. Ami lényeges az, hogy a kiválasztott üzenet a lehetségesen választható üzenetek csoportjába tartozik. A rendszert úgy kell megtervezni, hogy működjön minden lehetséges választásra, ne csak az éppen kiválasztottra." |

Devlin szerint az információ mindíg valamilyen helyzetből (szituációból) származik és diszkrét információs elemekből infonokból épül fel. Az infon maga objektumokból és az azokat összekapcsoló relációból áll. Tételezzük fel,hogy Jóska és Mari házasok. Ekkor j és m objektumok a személyek (Jóska és Mari) az R reláció pedig az, hogy házasok. Ekkor a σ -val jelölt infon a következő formába írható: σ = {R,j,m}. Az infonok ezután a halmazelmélet műveleteivel kezelhetők.

Devlin szituáció elméletében az embert információ feldolgozó egységnek tekinti, aki a nyelvet használja az információ feldolgozási műveletben. Szituáció elmélet lényegében az emberi nyelv matematikai leírása. Mivel a nyelv az információ megadásának az általunk ismert legfontosabb formája, ennek matematikai kezelése az információ matematikai leírásával kecsegtet. Devlin eddigiekben elért eredményei - amelyek még korántsem tekinthetők teljes, zárt matematikai elméletnek - az említett könyve, valamint a Situation Theory and Situation Semantics cimű munkája tartalmazza. |

|

Fizikai elméletek: Entrópia és Kvantumállapot

Sok félreértés származott abból, hogy Shannon információs entrópiának nevezte el az elméletében szereplő átlagos információ mennyiséget. Az elnevezés történetét M.Tribus és E.C.McIrvine írta meg az Energy and Information (Sci.Am, vol.224 p.178-184 1971) cimű cikkében. Elmondásuk szerint Shannon nem tudta, hogyan nevezze el ezt a mennyiséget. Megkérdezte magyar származású kollégáját, von Neumannt, aki a következőt javasolta: "Nevezd el információs entrópiának... [mivel]... senki nem tudja igazán mi is az entrópia igazából, így ha vitára kerül sor, te leszel előnyösebb helyzetben".Nézzük először, hogy mi is az entrópia. Ennek a fizikai mennyiségnek a világos bevezetése található meg - többek között - Morton A. Travel Information Theory (MIT Press and McGraw-Hill New York, 1989) cimű könyvében. A termodinamika rendkivül gyors fejlődésen ment keresztül a 19. században. Ennek ellenére a fizikusok nem találták annak magyarázatát, hogy a termodinamikai folyamatok miért csak egy irányban mennek végbe. Ezért bevezettek egy külön törvényt (a termodinamika második főtételét), mely szerint a zárt rendszerben, természetes, azaz külső energia befektetést nem igénylő, fizikai folyamatok során az entrópia nem csökkenhet. A bevezetés és az entrópia elnevezés Rudolph Clausius nevéhez fűződik. Clausius definiciója szerint a ΔS entrópia változás a vizsgált rendszer és a környezete közötti hőcsere valamint a rendszer hőmérsékletének a hányadosa: ΔS = ΔQ/T. Az egyenletben a távozó hő negativ, a belépő pedig pozitiv előjellel szerepel.

Tekintsünk az ábrán látható rendszert, amelyet egy hőszigetelő válaszfal két, egyenlő részre oszt. Az elválasztott részekben a hőmérsékletek a következők: T1 = 350 oK, illetve T2 = 300 oK. Ha eltávolítjuk a válaszfalat, akkor ΔQ hőmennyiség áramlik a magasabb hőmérsékletű helyről az alacsonyabba, és ΔS = ΔQ / T1 -el csökken az entrópiája. A távozó hő ΔS = ΔQ / T2 -vel növeli a másik rész entrópiáját. A teljes rendszer entrópiája növekszik, mivel T2 < T1. A leírt folyamat a termodinamikai egyensúly beálltáig: T = T2 = T1 folytatódik. Valójában, a belépő hő kicsit kevesebb mint a távozó, a hőtágulásra fordított munka következtében. Így a beálló közös hőmérséklet alacsonyabb lesz, mint a két rész átlag hőmérséklete.

Tekintsünk az ábrán látható rendszert, amelyet egy hőszigetelő válaszfal két, egyenlő részre oszt. Az elválasztott részekben a hőmérsékletek a következők: T1 = 350 oK, illetve T2 = 300 oK. Ha eltávolítjuk a válaszfalat, akkor ΔQ hőmennyiség áramlik a magasabb hőmérsékletű helyről az alacsonyabba, és ΔS = ΔQ / T1 -el csökken az entrópiája. A távozó hő ΔS = ΔQ / T2 -vel növeli a másik rész entrópiáját. A teljes rendszer entrópiája növekszik, mivel T2 < T1. A leírt folyamat a termodinamikai egyensúly beálltáig: T = T2 = T1 folytatódik. Valójában, a belépő hő kicsit kevesebb mint a távozó, a hőtágulásra fordított munka következtében. Így a beálló közös hőmérséklet alacsonyabb lesz, mint a két rész átlag hőmérséklete.

Clausius még nem tudta megindokolni, hogy miért áramlik a hő a magasabb hőmérsékletű helyről az alacsonyabba, növelve ezzel a rendszer entrópiáját. A magyarázatot később Ludwig Boltzman adta meg, a molekuláris szinten végbemenő folyamatok alapján. Ezekben a folyamatokban a valószínűségnek alapvető szerepe van. A folyamatok leírására értelemszerűen kinálkozott a valószínűségszámítás alkalmazási eszköze. a matematikai statisztika. A termodinamika ilyen megközelítését ezzel összhangban statisztikus mechanikának nevezzük.

A statisutikus mechanikában a rendszert számtalan mikroszkopikus részecske alkotja, amelyek mindegyike mikroszkópikus szerkezettel rendelkezik. A mikroszkópikus állapotok állandóan változnak, és ennek eredményeképp a rendszer a legvalószínübb állapotba kerül, amelyet makroszkópikus állapotnak nevezünk. Ez lényegében a legvéletlenebb szerű, rendszertelen mikroszkópikus konfigurációk összesége. A részecskék véletlenszerűen,céltalanul mozognak a makroszkópikus állapotban, külsőleg egyensúlyi állapotot mutatva.

A mikro és makro állapot jól modellezhető két dobókockával. Mindegyik kockának van 6 mikro-állapota.A két kockából álló rendszer 6x6 = 38 mikro-állapottal rendelkezik. 2 és 12 értékű állapot csak kétféleképpen állhat elő, míg 7 érték hat féleképpen. Ezért a makrosz- kópikus állapot a 7-s érték. Ennek mintájára, N darab dobókockának 6N mikroállapota lehetséges, és makroszkópikus állapota pedig 3.5N

Tekintsük most Clausius kettéválasztott rendszerét, de most legyen a két rész hőmérséklete azonos: T = T2 = T1 A mikro-állapotokat jelölje pi i=1,2...n, illetve rj j=1,2...n, az entrópiákat pedig S1=S2 Az entrópiák a p és r legvalószínübb mikroszkópikus állapotok függvényei, azaz S1= f(p), S2= f(r). Ha eltávolítjuk a válaszfalat, hő áramlás nem történik, mivel nincs hőmérséklet különbség a két rész között. A teljes rendszer entrópiája ekkor S = S1 + S2 lesz, a mikro-állapotok száma pedig pr, azaz S = f(pr). Igy fenn kell állnia az f(p) + f(r) = f(pr) egyenlőségnek. Mivel azonos matematikai eszközt használtunk, nem meglepő módon ugyanahhoz a matemetikai feltételt kaptuk, mint ami Shannon feltételéből adódott a kommunikációs rendszer vizsgálatánál. Ez a matematikai feltétel akkor elégíthető ki, ha az f függvény a logaritmus függvény, azaz S1 = S2 = lg(p) = lg(r) ami egy konstans szorzótól eltekintve a jól ismert Boltzman egyenlet.

Ha eltekintünk a tréfás jellegétől, Neumann javaslata az információs entrópia elnevezést illetően teljesen kézenfekvőnek tűnik. Matematikailag az egy jelre jutó átlagos információ mennyiséget - azaz az információs entrópiát - ugyanaz a matematikai függvény írja le mint a Boltzman által levezetett termodinamikai entrópiát. Felmerül a kérdés, a matematikai azonosság jelent -e valamiféle fizikai azonosságot?

Robert K. Logan egy nemrégiben publikált tanulmányában ( What Is Information?: Why Is It Relativistic and What Is Its Relationship to Materiality, Meaning and Organization Information 3,68-91,2012 ) részletes áttekintést ad erről a kérdésről. Három csoportba sorolja a kérdésben állást foglaló tudósokat. Az első csoport a termodinamikai entrópia inverzének, azaz fizikai tulajdonságnak tekinti az információt. A második csoport elutasít bármiféle kapcsolatot a termodinamikai entrópia és az információ között, és megkérdőjelezi az információ pusztán fizikai természetét. A harmadik csoport, amelyet főleg biológusok alkotnak, azt a nézetet képviseli, hogy a Shannon féle információ mennyiség nem vonatkozik a bioszféra evoluciójára, mivel az összes szóbajöhető lehetőség entrópiája kiszámíthatatlan ( Kauffman, S.; Logan, R.K.; Este, R.; Goebel, R.; Hobill, D.; Shmulevich, I. Propagating organization: An enquiry. Biol. Philos. 2007, 23, 27-45.).

|

Az első csoport álláspontját Maxwell 1867-ből származó véleménye alapozta meg. Maxwell egy elméleti kisérletet írt le, amelyben egy démon áll egy ajtóban amely két gázzal töltött tartályt választ el. A démon csak a gyors molekuláknak engedi meg, hogy az egyik tartályból a másikba távozzanak. Igy egy hőmérséklet különbséget hoz létre, megsértve ezzel a termodinamika második főtételét. Szilárd Leó 1929-ben vizsgálta ezt a problémát, és rámutatott, hogy a démon "információ beszerzése" valahol másutt megnöveli az entrópiát. Így nem sérül a második főtétel mivel az információ beszerzése következtében előidézett entrópia növekedés nagyobb lesz mint az az entrópia csökkenés, amelyet az információ alkalmazása előidézett. Szilárd vizsgálatát valaki úgy értékelheti, hogy az entrópia és információ ellentétes fizikai mennyiségek. N.Lewis szintén inverz kapcsolatot látott az információ és az entrópia között. Cikkében ( The symmetry of time in physics Science 1930, 71, 569-576) ezt a következőképpen fogalmazta meg: " Entrópia nyereség semmi más mint információ veszteség". Norbert Wiener, eltekintve az előjeltől, szintén a Shannon definiciót tekintette az információnak. Könyvében ( The Human Use of Human Beings Houghton Mifflin: Boston, MA, USA, 1950) ) a következőket írja:

Az első csoport álláspontját Maxwell 1867-ből származó véleménye alapozta meg. Maxwell egy elméleti kisérletet írt le, amelyben egy démon áll egy ajtóban amely két gázzal töltött tartályt választ el. A démon csak a gyors molekuláknak engedi meg, hogy az egyik tartályból a másikba távozzanak. Igy egy hőmérséklet különbséget hoz létre, megsértve ezzel a termodinamika második főtételét. Szilárd Leó 1929-ben vizsgálta ezt a problémát, és rámutatott, hogy a démon "információ beszerzése" valahol másutt megnöveli az entrópiát. Így nem sérül a második főtétel mivel az információ beszerzése következtében előidézett entrópia növekedés nagyobb lesz mint az az entrópia csökkenés, amelyet az információ alkalmazása előidézett. Szilárd vizsgálatát valaki úgy értékelheti, hogy az entrópia és információ ellentétes fizikai mennyiségek. N.Lewis szintén inverz kapcsolatot látott az információ és az entrópia között. Cikkében ( The symmetry of time in physics Science 1930, 71, 569-576) ezt a következőképpen fogalmazta meg: " Entrópia nyereség semmi más mint információ veszteség". Norbert Wiener, eltekintve az előjeltől, szintén a Shannon definiciót tekintette az információnak. Könyvében ( The Human Use of Human Beings Houghton Mifflin: Boston, MA, USA, 1950) ) a következőket írja:

"Az üzenetek maguk egy szervezettséget és mintát képviselnek. Valóban lehet hogy úgy tekintenünk az üzeneteket, hogy azok rendelkeznek entrópiával éppúgy mint az állapotok a valós világban. Az entrópia a szervezetlenség mértéke, az információ, amelyet pedig az üzenet sorozat szállít, a szervezettség mértéke. Ténylegesen lehetséges az, hogy úgy tekintsük az üzenettel szállított információt, mint alapvetően az üzenet entrópiájának negatív értékét, illetve valószínűségének negatív logaritmusát... Ez az információmennyiség az entrópiától pusztán az előjelében különbözik, eltekintve egy esetleges konstans faktortól." |

Wiener az entrópiát pozitívnak, míg az információt negatívnak, azaz az entrópia inverz sajátosságának tekinti, míg Shannon pozitív előjelet tulajdonitott az információnak. A különbség ellenére Shannon nagyra becsülte Wiener munkáját, amíről így írt:

"Elismeréssel kell adóznunk professzor Norbert Wienernek, akinek a stacionárius csoportok szűrési és becslési problémájára adott elegáns megoldása jelentős hatást gyakorolt ezen a területen a szerző gondolkodására." |

A klasszikus Shannon információt fizikai tulajdonságként kezelő tudósok mellett ebbe a csoportba sorolhatjuk a kvantum információ híveit. A kvantum információ egy fizikai tulajdonság, amelyet a kvantum rendszer állapota tartalmaz. Ezt az állapot vektor vagy ezzel ekvivalensen a hullámfüggvény írja le, szemben a klasszikus információval, amely csak egy meghatározott állapotra vonatkozik. Einstein fogalmazta meg először egyértelműen, hogy a kvantum állapotot úgy kell tekintenünk mint információt. A mai kvantum információs elméletben az információt fizikai entitásnak tekintik, ahogy azt Rolf Landauer megfogalmazta a The physical nature of information (Phys.Letters A 217 p.188-193 1996) cimű cikkében:

"Az információ fizikai tulajdonság... Az információ nem egy testetlen absztrakt entitás, mindíg tartozik hozzá valamilyen fizikai reprezentáció. Reprezentálhatja egy kőtáblába történt bevésés, a részecske spinje, egy lyuk a lyukkártyán, jelek a papíron vagy hasonló dolgok. Ezek kötődnek a valós világ adottságaihoz és korlátaihoz, annak fizikai törvényeihez és elérhető részeinek tárházához. " |

evolúciós operátornak létezik egy inverze, azaz a hullámfüggvény korábbi formája is egyértelműen meghatározott.

Az kvantum állapotban megtestesített információ alá van vetve ennek az alapelvnek, és ez ellentmondást rejt magába. Ez a modern kozmológia u.n. fekete lyuk információs paradoxona. 1975-ben Stephen Hawking és Jacob Bekenstein kimutatta, hogy a fekete lyukak lassan kisugározzák energiájukat. Ezt hívjuk Hawking sugárzásnak. Ha az az anyag, amelyik bekerült a fekete lyukba, tisztán kvantum állapotú anyag volt, a Hawking sugárzási folyamatban termikus állapotba kerül. Ekkor az eredeti kvantum állapot megsemmisül,azaz az információ elvész. Számos elmélet született ennek az ellentmondásnak a feloldására, Hawking maga is előadott egy elméletet 2004-ben. Eszerint az esemény horizont perturbációja megengedi az információ "megszökését" a fekete lyukból,így a paradoxon feloldható. Ebben a cikkeben nem szándékozunk elmerülni a fekete lyuk paradoxon körül folyó parázs vitákba, amely akkor került előtérbe, amikor a területen dolgozó fizikusok erőfeszítéseket tettek a kvantum elmélet és a relativitáselmélet egyesítésére. Beérjük azzal a záró megjegyzéssel, hogy szemben a Shannon elméletre alapozó elmélettel, amely az entrópiához kapcsolja az információ fizikai lényegét, a kvantum információs elmélet a kvantumállapotot tekinti információ fizikai entitásának.

evolúciós operátornak létezik egy inverze, azaz a hullámfüggvény korábbi formája is egyértelműen meghatározott.

Az kvantum állapotban megtestesített információ alá van vetve ennek az alapelvnek, és ez ellentmondást rejt magába. Ez a modern kozmológia u.n. fekete lyuk információs paradoxona. 1975-ben Stephen Hawking és Jacob Bekenstein kimutatta, hogy a fekete lyukak lassan kisugározzák energiájukat. Ezt hívjuk Hawking sugárzásnak. Ha az az anyag, amelyik bekerült a fekete lyukba, tisztán kvantum állapotú anyag volt, a Hawking sugárzási folyamatban termikus állapotba kerül. Ekkor az eredeti kvantum állapot megsemmisül,azaz az információ elvész. Számos elmélet született ennek az ellentmondásnak a feloldására, Hawking maga is előadott egy elméletet 2004-ben. Eszerint az esemény horizont perturbációja megengedi az információ "megszökését" a fekete lyukból,így a paradoxon feloldható. Ebben a cikkeben nem szándékozunk elmerülni a fekete lyuk paradoxon körül folyó parázs vitákba, amely akkor került előtérbe, amikor a területen dolgozó fizikusok erőfeszítéseket tettek a kvantum elmélet és a relativitáselmélet egyesítésére. Beérjük azzal a záró megjegyzéssel, hogy szemben a Shannon elméletre alapozó elmélettel, amely az entrópiához kapcsolja az információ fizikai lényegét, a kvantum információs elmélet a kvantumállapotot tekinti információ fizikai entitásának.

Kognitív elmélet: Különbség ami Különbséget okoz

Számos tudósnak nem tetszett, hogy az információt kapcsolatba hozták az entrópiával illetve a kvantum állapottal, és még kevésbé tetszett az, hogy az entrópia inverzének, vagy magának a kvantum állapotnak tekintették az információt. Schneider és Sagan írta a Into the Cool: Energy, Flow, Thermodynamics and Life ( University of Chicago Press: Chicago, IL, USA, 2005) című könyvében, hogy az "entrópia" terminus használata mind a termodinamikában mind pedig az informatikában zavaró, mivel "nincs egyszerű megfeleltetés a két elmélet között".Donald Mackay könyvében, Information, Mechanism and Meaning ( MIT Press: Cambridge, MA, USA, 1969.), egy másik megközelítést javasolt az információ természetének megértéséhez:

"... a probléma itt nem annyira az, hogy a legjobb kódolást találjuk meg valamelyik, átvitelre szánt üzenetre, hanem annak meghatározása, hogy mit és kinek küldünk... [Ezért az információ] az a változás a vevő tudatában, amit nem az üzenet jele, hanem annak jelentése okozott" |

A Shannon információ megfelel egy előre meghatározott adat együttes kiválasztott elemének, amelynek nincs szükségképpen semmilyen jelentése. Mackay szerint a kiválasztott információ nem elegendő, szükség van egy "strukturális" információra a kiválasztott információ megértéséhez és értelmezéséhez. Mackayt többen nem fogadták el a definiciójába foglalt szubjektivizmus miatt. Ha kiiktatjuk a "szubjektivitást" a művészetből, a társadalmi tudományokból,akkor a kognitív tudományok létezése megszűnik. Egyébként a szubjektív elem mellett elismerte az információ forrásának objektivitását. Először vezette be a következő megfogalmazást az információ tudományba:

" az információ egy megkülönböztetés ami változást hoz létre" |

amelyet később Gregory Bateson népszerűsített és öntött frappáns szavakba a Steps to an Ecology of Mind (Paladin: Frogmore, St. Albans, UK, 1973) cimű munkájában:

" a különbség ami különbséget okoz" |

Figyeljük meg a különbséget a Mackay definició és a Bateson szellemesen rövid megfogalmazása között. Mackay a szubjektív megítélésre utaló "megkülönböztetés" szót használja, míg Bateson az objektivitást tükröző "különbség" kifejezést.

Biológiai elmélet: a Sejt

Végül tekinsük át röviden azt az információ elméletet, amelyet a modern biológia szemléletének tekinthetünk. Stuart Kaufman definiált egy autonóm élő organizmust, amely önálló cselekvésre képes és önfenntartó rendszerként szaporodik legalább egy termodinamikai ciklus alatt. Más biológusokkal együttműködve (Logan, Este, Goebel, Hobill és Shmulevich) kidolgoztak egy alternatív elméletet az információra amelyet instrukcionális vagy biotikus információnak neveztek el. Az általuk kidolgozott információt kényszer és perem feltételek megadásával definiálták.A Shannon információ fogalmat, amelyik véges számú elemet tartalmazó halmazból egy elem véletlenül történő kiválasztásán alapszik, nem alkalmazható a biotikus (organikus) önszaporító rendszerre, mivel a fejlődésének lehetséges formái végtelen számú halmazt alkotnak. Kulcsfontosságú eltérés az a tény, hogy a Shannon információ a jelentésétől függetlenül definiált mennyiség, míg a biotikus vagy instruktionális definició szorosan kapcsolódik az organizmus információjához, nevezetesen ahhoz, ami a szaporodására vonatkozik. Úgy tekinthetjük a rendszeren belüli organizmust mint olyan információ formát, amely tartalmazza a szaporodáshoz szükséges adatokat. Ez egy sokkal dinamikusabb leírás mint a Shannon információ, amely pusztán bitek vagy szimbólumok sorozata. , A biotikus információ, azaz a biológiai organizmus, az önszaporító jellege következtében növekszik és sokszorozódik - nem úgy mint a Shannon információ. Az említett biológusok csoportja munkájukban megfogalmazzák a következőket:

"A biotikus organizmus többet jelent mint egy organikus leves. Ugyanakkor a strukturált és szervezett élő organizmus kevesebb Shannon információval rendelkezik. Ez kontraproduktiv a biológus számára az élő organizmus megértésében. Ezért úgy véljük, hogy a Shannon információ fogalom nem érvényes a biotikus rendszer leírására. A Shannon információ a biotikus rendszer esetében egyszerűen egy fogalmi hiba. Egy élő organizmusn jelent valamit a világban, és saját maga egy automóm szereplő. A véletlen összetételű, organikus vegyületekből álló levesnek nincs jelentése és szervezettsége." |

A Shannon megközelítés (egy elem véletlen szerű kiválasztása véges számú elemet tartalmazó halmazból) jelentősen eltér a biotikustól (a kiválasztást végtelen sok lehetőségből korlátozó feltételek határozzák meg) és úgy tűnik, hogy az entrópia koncepció kevésbé antagonisztikus. Erwin Schrödinger a What is Life? (Cambridge University Press: Cambridge, UK, 1992) cimű könyvében a következőket írja:

| "Minden folyamat, esemény, történés - hívjuk ahogy tetszik - azaz egyszóval minden, ami a Természetben megtalálható, növeli az entrópiát abban a részben ahol végbemegy. Így, egy élő organizmus folyamatosan növeli a saját entrópiáját - vagy, ahogy mondhatjuk, pozitiv entrópiát produkál - és így közelíti azt a maximális entrópia állapotot amelyet halálnak nevezünk. Ettől csak úgy tarthatja távol magát, azaz úgy maradhat életben, hogy folyamatosan elvon a környezetétől negatív entrópiát, ami egy nagyon pozitív cselekvés, ahogy azt hamarosan látni fogjuk. Ami egy organizmust táplál az negatív entrópia. Vagy, kevésbé paradox módon megfogalmazva, a metaboliznusban alapvető fontosságú az a folyamat, amelyben az organizmus megszabadul mindattól az entrópiától, ami nem segíti az életben maradását." |

|

Zárszó

Az információ mibenlétének négy megközelítését fogalmaztan meg ebben a cikkben - matematikai, fizikai, kognitív és biológiai szubjektív elnevezéssel. Shannon valószínűségi és Devlin halmazelméleti modeljét soroltam a matematikai koncepcióba, Szilárd és Wiener negatív entrópia és Landauer kvantumállapot elképzelését a fizikaiba, Mackay jelentés orientációját a kognitívba, és végül Kaufmann és társainak biotikus információját a biológiai megközelítésbe. Ezek az elméletek különbözőképpen vélekedtek az információt hordozó konténer és a hordozott információ viszonyáról és relatív fontosságukról. Némelyikük szigorúan megkülönböztette, mások elválaszthatatlannak vagy éppen azonosnak vélték őket. Mindemellett megítélésem szerint az elméletek közötti fő eltérés, ha ügy tetszik demarkációs vonal, nem ebben keresendő, hanem az információ természetének, mibenlétének megítélésében. Leegyszerűsítve a materialista nézet, amely az információt a Természet objektív attributumának, valamiféle alaptulajdonságának véli mint az anyag, energia, tér és idő illetve a spirituális szemlélet, amely pusztán szellemi terméknek tartja. A bizonytalanságot ennek az alapkérdésnek a megítélésében - még egyazon személy esetében is - jól tükrözi Norber Wiener, két, szinte azonos időben (!) keletkezett munkájából vett idézet. Ime az első, korábban már idézett részlet ( The Human Use of Human Beings Houghton Mifflin: Boston, MA, USA, 1950):

"...Ténylegesen lehetséges az, hogy úgy tekintsük az üzenettel szállított információt, mint alapvetően az üzenet entrópiájának negatív értékét, illetve valószínűségének negatív logaritmusát... Ez az információmennyiség az entrópiától pusztán az előjelében különbözik, eltekintve egy esetleges konstans faktortól." |

és a második (Cybernetics, or Control and Communication in the Animal and the Machine. John Wiley and Sons, lnc., New York, 1948.):

| "... az információ az információ és nem anyag vagy energia" |

Katherine Hayles aki az információ aspektusát filózofiai szempontból vizsgálta, az alábbi következtetésre jutott az információ elméleteket illetően ( How We Became Posthuman University of Chicago Press: Chicago, IL, USA, 199 ):

"...az információ elmélet információt gyárt mint valamiféle hatalmi és ellenörző szerv az anyagi világ felett " |

Végül, megpróbáltam egy áttekintő táblázatba foglalni a cikkben ismertetett információ elméleteket:

| matikai |

|

|

|

|

|

elmélet |

| |

||||||

| |

|

|||||

elmélet |

állapot |

|||||

| |

||||||

| |

|

|||||

| |